本文相应的代码附在文章末尾处。

场景描述

- 1个生产者只与1个消费者相互绑定。

- 生产者按固定生产频率,每间隔

<PRODUCE_INTERVAL_MS>毫秒生产一个任务。 - 生产者每次生产时都检查当前任务队列大小,如果已经超过

<QUEUE_NUM_CANCEL_PRODUCE>,则丢弃本次生产的任务。(即消费能力低于生产能力时如何处理) - 总共有

<PAIR_NUM>对(pair)单生产者单消费者对,对与对之间没有逻辑关联。(增大模拟性能场景)

测试方法

分别使用golang的channel和条件变量作为生产消费的通信手段。

让测试程序执行<TEST_DURATION_SEC>时长后退出。

观察测试程序执行时cpu的使用情况,以及最后总共生产任务的数量和消费任务的数量。

使用条件变量时,先进先出任务队列底层使用golang的slice实现。

channel使用的是带缓冲的channel。缓冲大小为<QUEUE_NUM_CANCEL_PRODUCE>的2倍。

测试结果

测试时条件设定:1000个生产消费对,每个生产者的生产间隔为50毫秒,总测试时长为1分钟。

理论任务数量:1000 * 600 * 20 = 12000000

实际任务情况:

| 类型 | 总生产任务数 | 总消费任务数 | 总丢弃任务数 |

|---|---|---|---|

| channel | 11964475 | 11964475 | 0 |

| cond | 11960068 | 11960068 | 0 |

分析:

由于程序中总测试时长和生产者的生产间隔都使用sleep实现,并且程序是执行固定时间后强行退出,所以数量可能存在误差,误差在可接受范围内。

无论是channel还是cond,总生产任务数都等于总消费任务数,符合预期。

由于消费者只做计数统计不做其他业务,不会出现消费能力低于生产能力的情况,

而<QUEUE_NUM_CANCEL_PRODUCE>又设置的比较大(1000),所以生产者没有丢弃过任务。

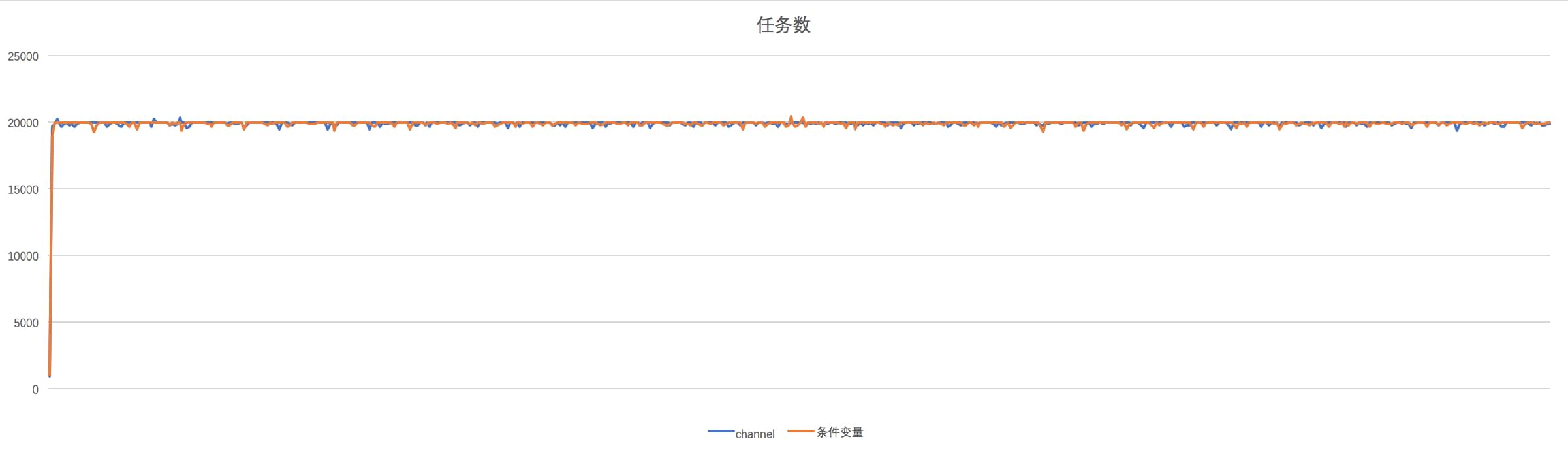

以下是每秒任务数随时间轴变化折线图:

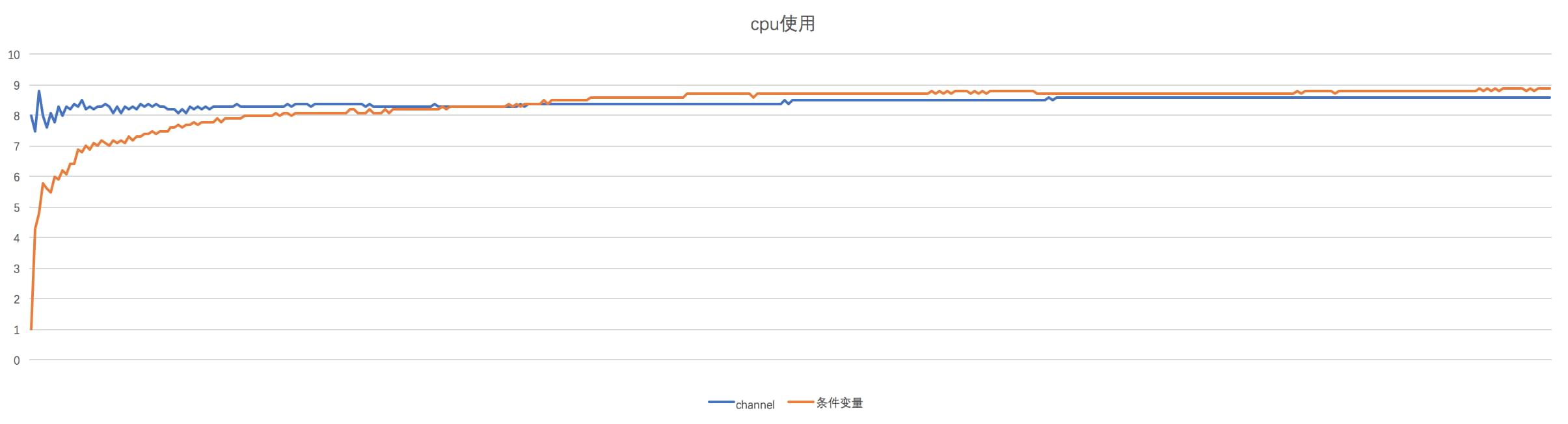

cpu使用对比

cpu平均使用率

- channel:8.44%

- cond:8.37%

以下是每秒cpu使用率随时间轴变化折线图:

测试代码

1 | package main |

其他

对channel使用len获取当前大小是否线程安全

用len获取当前channel的大小是线程安全,但是由于获取大小、读取元素、写入元素是三个独立的操作,所以,获取了长度之后在做写入元素的操作时长度可能已经发生变化。

对于我们例子的场景,这种变化是可接受的。即在获取大小并判断得出已超过channel的生产阈值之后,消费协程可能又消费了一些元素,此时channel的大小可能比阈值要小,但我们依然丢弃当前元素的写入。

TODO

希望后续如果有时间有能力可以看看golang中channel的实现原理,slice的实现原理,container list的实现原理。

本文完,作者yoko,尊重劳动人民成果,转载请注明原文出处: https://pengrl.com/p/24468/